ITヘルプデスクへの導入で、大きな成果を上げたAIチャットボット

多くの企業には、様々なITサービスが導入されており、ITヘルプデスクに寄せられる質問も、ファイルサーバーの接続トラブルや全社員が共通して使うメールなどの業務ツール、電子稟議書など社内ワークフローシステムの利用法、スマートフォンの初期設定方法まで多岐にわたる。また、利用する場面や状況、使っている機器が利用者によって異なるため、ITヘルプデスクの問い合わせ対応にはどうしても時間がかかる。

たとえば、大手製薬メーカーのA社では、わずか5人のスタッフが約4,000人の社員に対してITヘルプデスクのサービスを提供していた。ITヘルプデスクの業務負担増が問題となっていた同社では、DX推進の流れのなかで、AIチャットボットを導入し、大きな効果を生んだ。

そもそも、多くの企業に導入されているAIチャットボットの基本的な仕組みは、知識データベースと質問応答エンジンの組み合わせだ。つまり、考えられる質問と回答のリストを知識データベースに蓄積し、質問応答エンジンで最適なマッチングを実現するわけだ。そして、AI学習によってマッチング精度を向上させることで、自動応答が可能になる。

ただし、AIチャットボットは万能ではない。もっとも威力を発揮するのは、ユーザーが自己解決できる質問への対応だ。つまり、FAQへの案内や情報提供で代替できる質問である。自己解決可能なQAが少ない場合、AIチャットボットの効果は限定的となる。

そのため導入にあたっては、自己解決型の質問ボリュームの分析が必要になる。その分析を担うのがPoCだ。A社でも、PoCによりチャットボット導入効果を検証したことが成功につながったという。では、PoCはどのように実施され、その勘所はどこにあるのだろう。

成功するAIチャットボット導入の定石は、データ分析とPoC

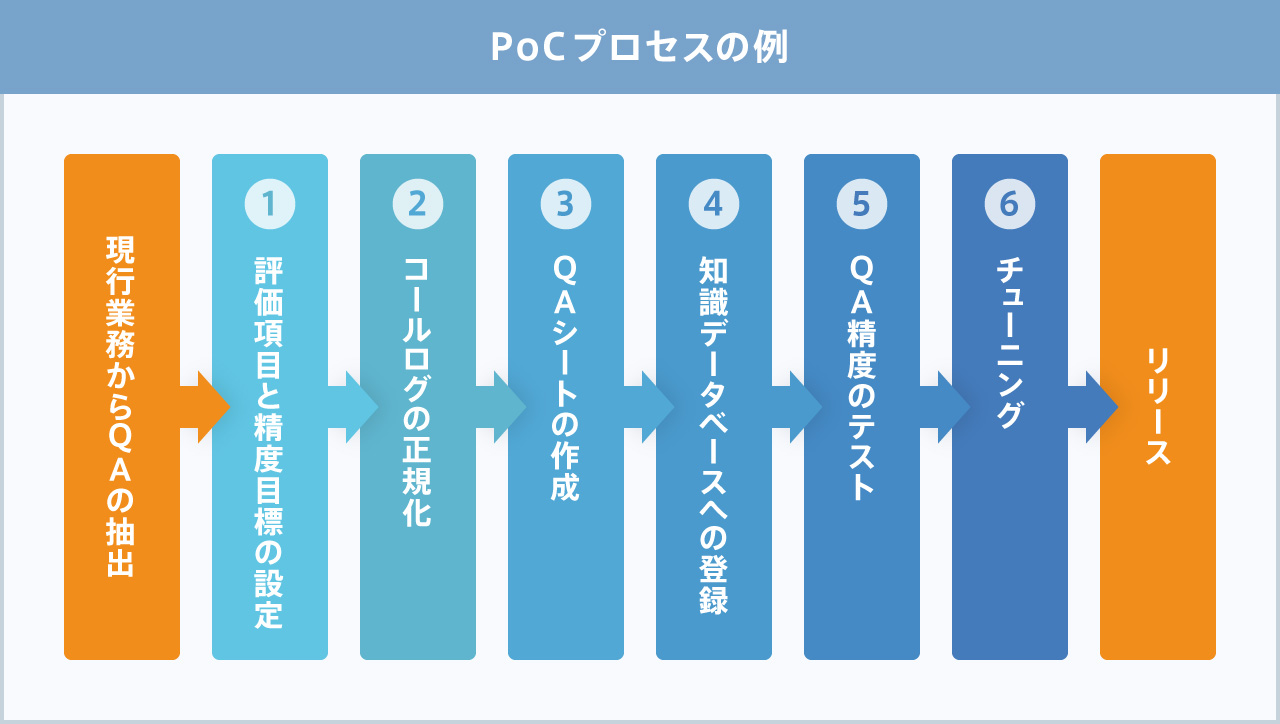

PoCは、以下のようなプロセスで進められた。まず、「データがそろっているか」「PoCで何を効果検証するか」を決めた。検証範囲は期間とコスト次第だ。ただし最低限、「現在のデータを使って正しい答えが出るか」「どのくらいの精度になるか」は検証することになる。

次は、評価項目と回答精度の目標設定。評価項目は、正答率や利用者評価(good or bad)、利用時間帯(特に、ヘルプデスクの稼働時間外の利用)、誤字脱字での正答率、その他アンケート評価など。回答精度の目標は8割以上に設定した。

その上で、A社はPoC実施領域をiPhoneカテゴリに絞った。チャットボット導入のPoCでは通常、全領域を対象に実施することはない。利用頻度が高く、汎用化しやすく、3カ月から半年程度で効果が見える領域を選び、実施する。「導入して成果が出るのか」をできるだけ短期間で見極めるのだ。

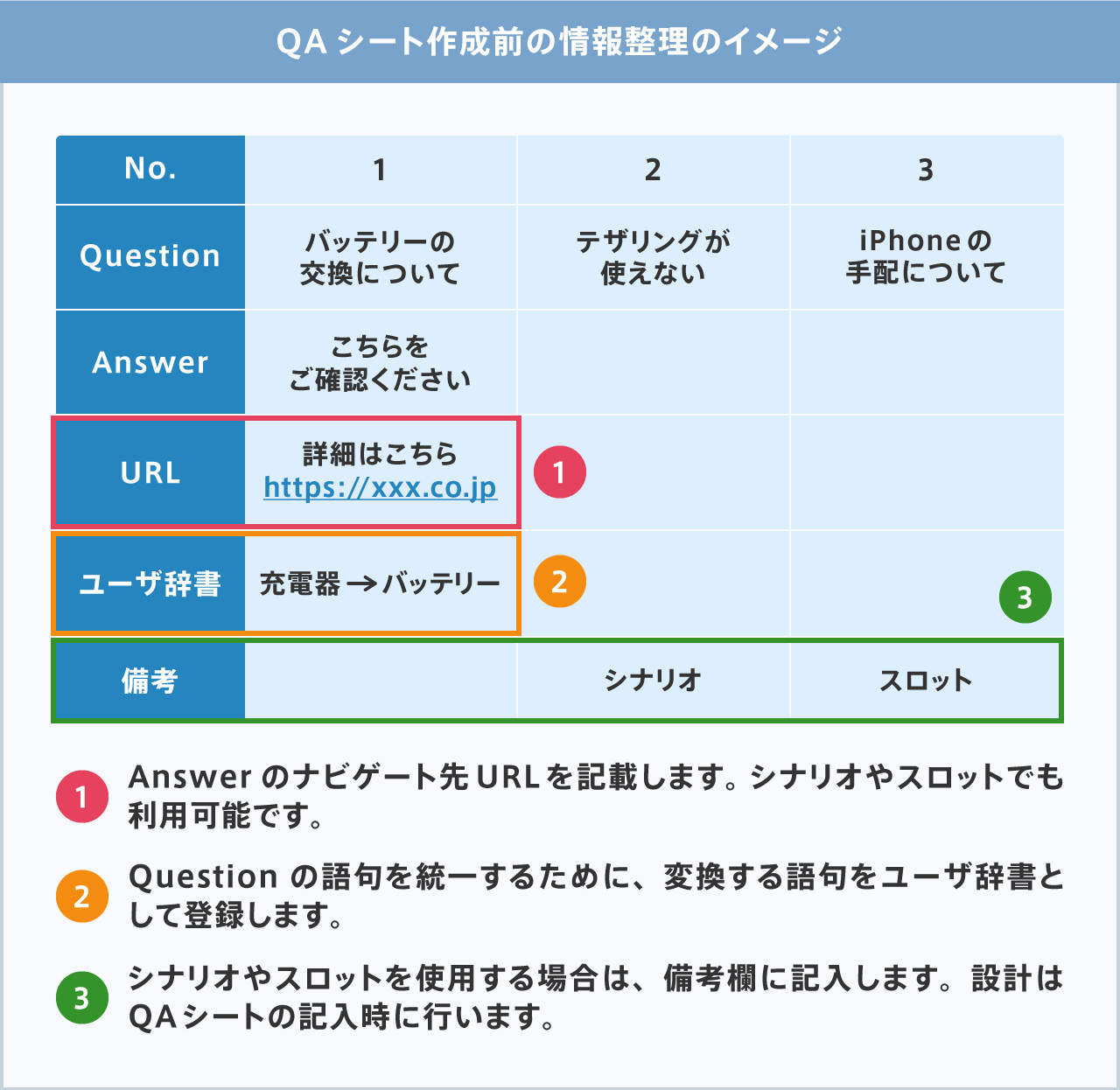

次のステップは「コールログの正規化」だ。要は、FAQやコールセンターの応対データなどをAIチャットボットが正しく回答できるように整理して、知識データベースに登録するQAシートを作成し、ナビゲート先のURLなどを追記する。そのため、事前にQAシートの作り方の講習を受けた。

では、FAQや応対データがないときにはどうすればいいのだろう。その場合、コールセンターであれば、3カ月から半年程度の音声ログから書き起こすことになる。ITヘルプデスクや人事・総務などへの導入であれば、メールでの応対データなどが参考になるだろう。それも難しければ、「実際にどのような問い合わせがあり、それにどのように答えているか」をヒアリングして作成するのだ。

QAシートを作成して、知識DBにアップロードしたら、QAの精度をテストする。実際に検索されるであろう、様々な質問のパターンを作成し、きちんとした答えが得られるかをチェックするのだ。

当然、きちんと答えられる質問もあれば、答えられない質問も出てくる。その結果を受けて、8、9割の正答率になるまで知識データベースを修正する。この「チューニング」作業によって、間違った答えが提示された質問に対して、正しい答えを返せるようにするのだ。

この段階で、A社ではテストリリースを実施した。限られたユーザーに公開して、実際に質問してもらったのだ。その結果をレポートにまとめ、問題ないと判断し、今度はいよいよ、利用者全員に公開する本格リリースへと移った。

稼働後には、チューニング作業についての運用トレーニングを受けた。運用トレーニングは通常、実際のログデータを使って実施する。チューニングを続けることで、回答精度の高いAIチャットボットの運用が可能になるのだ。

正答率を上げる鍵は、正規化とチューニング

PoC、ひいてはAIチャットボット導入を成功させる上で、最も重要になるのが正規化のプロセスだ。すなわち、QAシートを作成するにあたり、重複したQAを整理する、複雑な質問をシンプルにする、Qをなるべく短くする、語句、語尾を統一するといった作業をする。

そもそも、QAには、正規化に向いているものと向いていないものがある。向いているのは、QとAが1対1で回答をパターン化できるもの。たとえば、手続きに関する質問と回答だ。一方、向いていないのはQが複雑で回答のパターンも多いもの。つまり、回答を絞りにくい質問となる。

元データをきちんと正規化せずにQAデータを作成すると、チャットボットの回答精度は上がらない。たとえば、「連休前で新幹線の指定席チケットが予約できなかったので、グリーン車に乗りました。出張精算は可能ですか」といった質問があれば、まずは「グリーン車に乗りましたが、出張精算は可能ですか」という質問に分解し、なぜ「グリーン車に乗ったのか」を聞き返すことになる。

このように、「質問に対するユーザーの選択によって会話が分岐する(ユーザーの回答によって条件が変わり、チャットボットの回答が変わる)機能=シナリオ」や「あいまいな質問に必要な情報(スロット)を聞き返し適切な回答に導く機能=スロットフィリング」も、この正規化の段階で設計することになる。

こう聞くと難しく感じるかもしれない。しかし実際には、コールログに残されたやり取りがシナリオになる。逆に言えば、聞き返しが入る質問、回答が質問の順番に依存する質問はシナリオに向いていると言えるだろう。またスロットフィリングに向いているのは、条件が複数ある場合に条件を質問者に選ばせる質問だ。

QAシートは、内容を一番理解しているユーザーが作成して、正規化するのが望ましい。その上で、A社のケースでは、SCSKのAIチャットボット「Desse(デッセ)」のエンジン特性を熟知しているSCSKが正規化後の表現をチェックした。双方が協力した結果、本当に現場で使えるAIチャットボットを構築できたのだ。

また、回答精度をさらに高めていく上では、QAのメンテナンスとそれに伴うチャットボットのチューニングが極めて重要になる。チューニングでは、間違った答えが提示された質問に対して、「学習データ=言い回し文」を追加する、しきい値を変更するといった作業を行うことになる。

しきい値を変えると表示される回答も変わるので、回答結果を見ながらしきい値を調整する。場合によっては、登録しているQ自体を変更したり、シナリオやスロットフィリングを作成したりする。Qを分割したり、言い回しをわかりやすく変えたりすることで、回答にたどり着きやすくするのだ。このあたりの作業は、ユーザーが自らやるか、それともSCSKに任せるかを相談しながら決めていく。

A社でDesseを利用した社員は、ITヘルプデスクの利便性向上を実感しているという。実際、電話やメールの問い合わせ数は約3割減った。しかもDesseの稼働率は全期間を通じて100%、問い合わせの正答率は91%だ。

これまでのように電話をかけるという面倒がなく、デスクトップ上のPCや出先のスマホから気軽に問い合わせることが可能だ。夜間や早朝のため、すぐに解決できなかったトラブルや疑問もその場で解決できる。抱えている業務を止めることなく、すぐに次の仕事に取り組めるという声も多かった。

市場には多数のAIチャットボットが存在するが、その基本的な仕組みに大きな差はない。質問に対して答えを提示するというものだ。では何を基準にして、製品やサービスを選べば良いのだろう。それは、エンジン性能や正答率を上げる工夫である。これによって、AIチャットボットが正しく回答できるのか決まってくるからだ。

またエンジン特性の理解は、回答精度向上につながる。エンジンの仕組みを理解していれば、性能・機能・学習データの組み合わせでチャットボットを設計できるからだ。そこが、他社製品を扱うベンダーではなく、自社製品を持つベンダーに依頼するメリットである。

製品選びでは、「正規化後の表現チェックをどこまでフォローしてくれるか」「導入後にどの程度フォローしてくれるか」も重要になるだろう。そこが、使用感を大きく左右するためだ。

Desseは本格リリース後に運用トレーニングを実施するなど、サポートが手厚い。ITヘルプデスクや人事・総務における応対業務を効率化したいのであれば、一度検討してみる価値はありそうだ。